Die Auswahl von Studienergebnissen durch Wissenschaftsjournalisten erschien lange als relativ beliebig. Dank neuer Analysetools sind jetzt Einsichten möglich, die das Auswahlhandeln in ein neues Licht tauchen. Eine davon: Die Auswahl folgt wahrscheinlich einer mathematisch exakt zu beschreibenden Gesetzmäßigkeit. Ein Werkstattbericht. VON MARKUS LEHMKUHL

Es passierte an einem Mittwoch Ende November vergangenes Jahres. Ich saß an meinem Schreibtisch und studierte die Verteilung von Artikeln über neue wissenschaftliche Resultate. Eine der Datenreihen zeigte an, wie häufig über eines der etwa 2,3 Mio wissenschaftlichen Resultate eines Jahres berichtet worden ist. Eine weitere zeigte an, durch welche der von der Datenbank Scopus gelisteten 24 000 wissenschaftlichen Zeitschriften diese Ergebnisse veröffentlicht wurden.

Beide Datenreihen entstammen einer automatisierten Abfrage des Altmetric Servers. Altmetric ist eine Firma, die prinzipiell für jedes Dokument, das mit einer DOI versehen ist, nachvollzieht, wo im Netz auf dieses Dokument verlinkt wird. Diese Quellen werden Kategorien zugeordnet, eine davon sind Massenmedientitel. Wenn etwa bei spiegel_online über eine Studie berichtet wird, dann weist Altmetric das entsprechend aus.

Was ich beim Blick auf die Datenreihen zu sehen bekam, war zunächst nicht besonders überraschend, aber trotzdem interessant, weil bisher unbekannt. Nur gut 2 200 Studien, also knapp 0,1 Prozent, stoßen auf ein Echo im Journalismus. Die Resultate stammen aus gut 700 unterschiedlichen Journals. Also bringen immerhin etwa drei Prozent der Journals in einem Jahr mindestens ein Paper raus, das durch Journalisten irgendwo auf der Welt ausgewählt wird. Das war eine für mich überraschend große Zahl. Ich hätte nicht gedacht, dass aus so vielen unterschiedlichen Journals ausgewählt wird. Ich notierte mir einen Kommentar in mein Notizbuch: „Wahrscheinlich ein Effekt von EurekAlert, AlphaGalileo, Sciencedirect und Co!“

Will sagen: Dass nur einzelne Paper aus Journals mit häufig mehr als 1000 Veröffentlichungen pro Jahr ausgewählt werden, kann man nicht dadurch erklären, dass diese durch unabhängige Wissenschaftsjournalisten systematisch beobachtet werden. Es ist wahrscheinlich, dass das auf das Konto der Kommunikationsprofis geht, die im Auftrag von Hochschulen oder Verlagen fleißig Pressemitteilungen über mutmaßlich journalistisch anschlussfähige Resultate auch aus eher unbekannten Journals auf den Fachportalen und anderswo verbreiten.

Acht Zeitschriften veröffentlichen ein Viertel aller resonanzstarken Studien

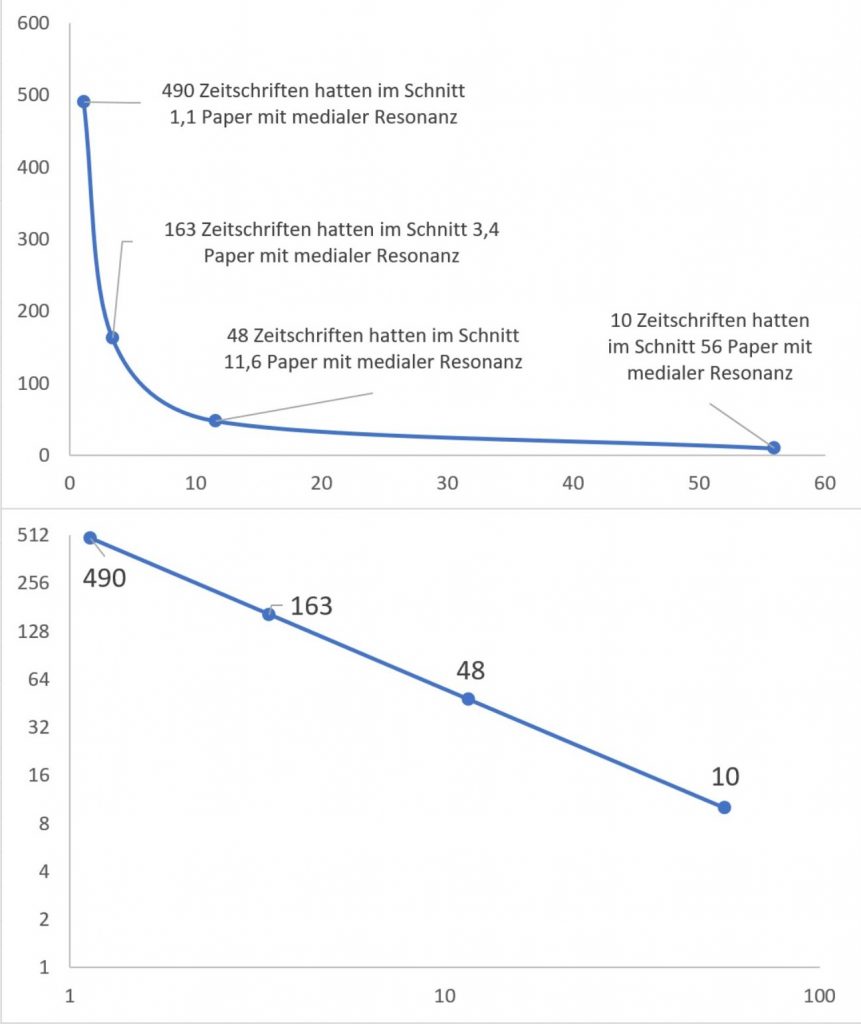

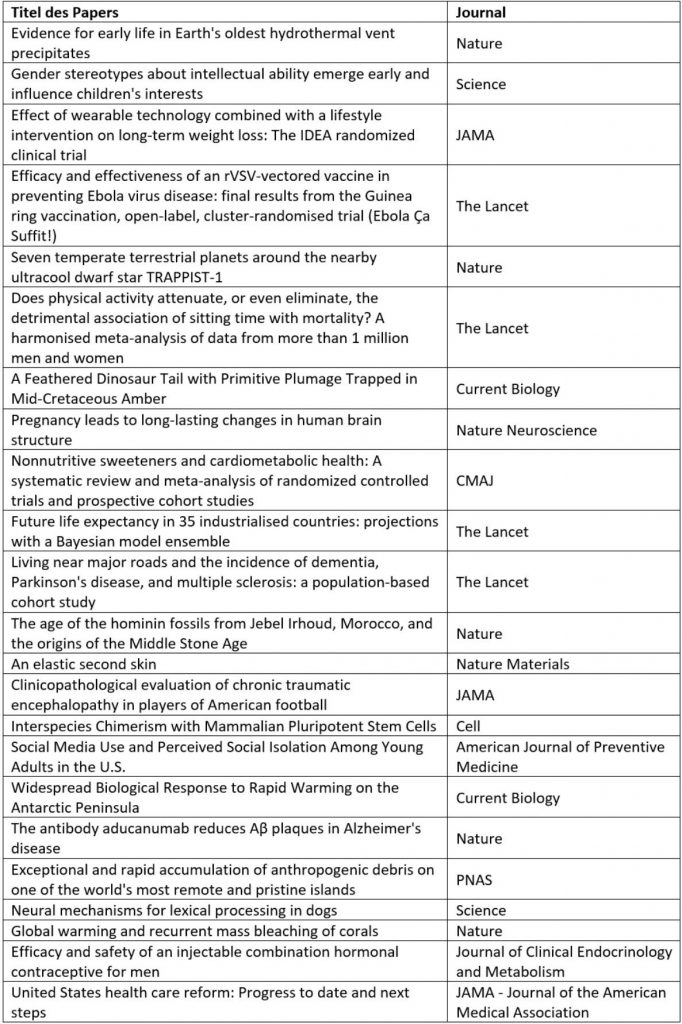

Ich begann die Datenreihen in zwei Grafiken zu überführen. Was ich zu sehen bekam, war eine so genannte „Long-Tail-Verteilung“. Das bedeutet: Die allermeisten Paper und die allermeisten Journals finden im Journalismus nur äußerst mäßige Beachtung. Etwa 425 der gut 700 Journals, aus denen die Wissenschaftsnews eines Jahres stammten, haben binnen eines Jahres nur ein Paper veröffentlicht, das Beachtung fand. Mehr als ein Fünftel der Studien, also etwa 500, sind in nur acht Journals erschienen: Science, Nature, Nature Communications, PNAS, Lancet, New England Journal of Medicine, JAMA und Pediatrics. Von den 2200 Resultaten brachten es ungefähr zwei Dutzend zu weltweiter Aufmerksamkeit, d.h. sie wurden von vielen Journalisten in vielen Ländern gleichzeitig ausgewählt, man kann sie deshalb als die Top Science World News des Jahres 2016/2017 bezeichnen (siehe die Liste am Ende dieses Beitrages).

Dass ich mich noch an den Wochentag erinnere, an dem ich diese Analysen machte, wird durch diese Einsichten jedoch noch nicht erklärt. Erst der nächste Analyseschritt erklärt das. Er erbrachte nämlich zwei krumme Zahlen, die mich elektrisierten: .97 und .95! Diese Zahlen geben Auskunft darüber, wie exakt sich Long Tail verteilte Messpunkte an eine Gerade schmiegen, wenn man die Daten auf eine Skala abträgt, die logarithmisch ist. Der Wert 1 wird erreicht, wenn jeder Messpunkt genau auf der Geraden liegt. Das bedeutet bezogen auf die Journals: Die Chance, dass ein Journal 1,2,3…. Paper veröffentlicht, die auf Resonanz im Journalismus stoßen, nimmt mit nachgerade unheimlicher Regelmäßigkeit exponentiell ab, der Exponent der Steigung beträgt 2,2. Bezogen auf die einzelnen Studien: Die Chance, dass eine Studie X durch 50, 51, 52… Medientitel weltweit aufgegriffen wird, fällt mit jedem weiteren Medientitel, der auswählt, ziemlich steil und absolut regelmäßig ab. Der Exponent der Steigung beträgt 3,4.

Darstellung der Häufigkeit von Journals, in denen genau x Paper veröffentlicht wurden, die auf mediales Interesse gestoßen sind. In der unteren Abbildung sind die Messwerte auf logarithmischen Skalen abgetragen, hier zeigt sich eine Gerade.

Die journalistische Auswahl wissenschaftlicher Studien folgt einer klaren Verteilung

Jetzt wurde ich richtig aufgeregt. Ich wähnte mich schon als Entdecker eines bisher unbekannten Verteilungsgesetzes. Die Freude darüber währte allerdings nur kurz, sehr kurz. Ich griff hinter mich in mein Bücherregal und zog ein Buch heraus, das erstmals 1963 veröffentlicht wurde. Geschrieben hat es Derek de Solla Price, vom dem die noch heute immer wieder zitierte Rate stammt, mit der die Wissenschaft seit ihrem Bestehen jährlich wächst, etwa drei Prozent. Ich erinnerte mich vage, dass ich in diesem Buch so etwas Ähnliches wie das, was sich vor mir auftat, schon Mal gesehen hatte. Und richtig: De Solla Price stützte damals seine Hochrechnungen unter anderem auf Lotkas Gesetz, erstmals beschrieben 1926.

Es besagt im Wesentlichen, dass grundsätzlich immer ein vergleichsweise großer Teil der Publikationen innerhalb eines Fachgebietes auf eine vergleichsweise kleine Zahl von Autoren entfällt. Lotka fand, dass die Anzahl der Autoren, die n Aufsätze schreiben, proportional zu 1/n2 ist. Das entspricht prinzipiell der Verteilung der durch Journalisten ausgewählten Paper auf die Journals. Der einzige Unterschied ist, dass der Exponent leicht differiert: Meine Gerade fällt nicht ganz so steil ab wie die von Lotka. Das Lotkasche Verteilungsgesetz ist mittlerweile für viele unterschiedliche wissenschaftliche Fachgebiete mehr oder minder reproduziert worden. Das heißt, man kann davon ausgehen, dass in wissenschaftlichen Fachgebieten auf 100 Autoren, die in einem bestimmten Zeitraum einen Aufsatz verfassen, 25 kommen, die zwei schaffen, 11 drei usw.. Meine Daten zeigen, dass auf 100 Journals, die 2016/2017 ein Paper in die Zeitung brachten, 28 kommen, die zwei schafften, 10 drei, 7 vier, 5 fünf usw., ganz am Ende dieser Reihung findet sich Science. Das Journal brachte es auf immerhin 86 Paper.

Noch ein wenig ernüchterter wurde ich, als ich feststellte, dass diese Art der Verteilung schon für einen ganzen Strauß von Merkmalen gefunden wurde. Eine kleine, nicht vollständige Liste: Größenverteilung von Städten, Größe von Mondkratern, Häufigkeit der Wahl bestimmter Wörter in allen menschlichen Sprachen, die Zahl der Zitationen von wissenschaftlichen Aufsätzen, die Zahl der Zugriffe auf Webseiten, die Verkaufszahlen von Büchern, die Größenverteilung US-amerikanischer Unternehmen… . Das, was ich vor mir hatte, war also mitnichten ein neues Verteilungsgesetz. „Entdeckt“ hatte ich allenfalls ein weiteres „man made system“, das so wie einige andere offenbar durch irgendeine unsichtbare Kraft getrieben so eine Art von Verteilung hervorbringt: die journalistische Auswahlpraxis wissenschaftlicher Studien.

Aber, was ist diese Erkenntnis wert? Was bedeutet sie überhaupt? Antworten erarbeiten wir in einem kleinen Team am Karlsruher Institut für Technologie (KIT) zusammen mit dem Science Media Center in Köln. Ich halte Sie auf dem Laufenden!

Top Science World News des Jahres (2016/17)

Markus Lehmkuhl ist Professor für Wissenschaftskommunikation in digitalen Medien am Karlsruher Institut für Technologie.

Markus Lehmkuhl ist Professor für Wissenschaftskommunikation in digitalen Medien am Karlsruher Institut für Technologie.

Kommentare

Anonym schreibt:

19. Juni 2018 um 09:26 Uhr

Herzlichen Glückwunsch, die großen Journale mit höherem Impact ziehen die Arbeiten an, die mehr Leute interessieren könnten, die dann auch mehr besprochen werden. Trotzdem interessant, dass das so einfachen Verteilungen folgt.

Redaktion schreibt:

19. Juni 2018 um 09:11 Uhr

Was mich interessieren würde ist der Anteil der Publikationen in den Journals mit 1 oder 2 Social Impact Papern pro Jahr, die ohne Pressemitteilung in Eurekalert/idw/alpha Galileo aufgegriffen wird: Die Vermutung wäre, dass es sich um sehr wenige bis gar keine Publikationen handelt. Aber Ausnahmen von dieser Regel wären interessant.

Redaktion schreibt:

19. Juni 2018 um 10:31 Uhr

Es ist gut möglich, dass es solche Publikationen gibt, wir haben die aber bisher nicht gefunden. Was wir gemacht haben: Wir haben eine Zufallsstichprobe von 100 der gut 2200 Papern ausgewählt und überprüft, wie viele davon bei EurekAlert auftauchten. Ermittelt haben wir (nur) 60 Prozent, also 6 von 10 Studien tauchen bei EurekAlert auf. Diesem Ergebnis traue ich aber nicht, erstens weil wir noch kein gutes Verfahren haben, um EurekAlert wirklich effektiv zu durchsuchen (eine amerikanische Gruppe hat so ein Verfahren, ich hoffe, dass die uns das überlassen). Zum anderen haben wir andere Plattformen wie AlphaGalileo nicht durchsucht. Darüber hinaus haben wir bei bislang nur einer sehr kleinen Zahl von Papern genau rekonstruiert, wie die in die Presse gelangt sind. Unter diesen Einzelfällen war aber keiner, der nicht über EurekAlert lief.

Markus Lehmkuhl

Moritz Kaiser schreibt:

19. Juni 2018 um 09:26 Uhr

Interessant sind meiner Meinung nach Ausreißer oder es wäre interessant gewesen, wenn Knicke in der Linie sind. Das würde nämlich eine gezielte Einflussnahme belegen. Oder auch nicht 🙂

Interessante Frage ist auch, wie genau der Exponent zustande kommt. Kann man ein Modell für die Dynamik dahinter stricken und was bedeutet das für zukünftigen Wissenschaftsjournalismus, wenn das mal jeder Wissenschaftsjournalist verinnerlicht hat?

Redaktion schreibt:

19. Juni 2018 um 11:01 Uhr

Also wenn man an so etwas wie Gaußsche Normalverteilungen denkt, dann muss man wohl sagen, dass diese so genannten „power law distributions“, wie wir die hier sehen, voller Ausreißer sind, das gilt natürlich besonders für die Top news, das sind ja sämtlich absolute Ausreißer nach oben. Es gibt zwar, wenn man das anders darstellt als ich es in dem Beitrag gemacht habe, manchmal Messpunkte, die nicht genau auf der Linie liegen, allerdings gibt es keine Ausreißer in dem Sinne, dass Messpunkte sich weit von der Linie entfernten, wenn das so wäre, wäre das Bestimmtheitsmaß der Regressionsgraden nicht .95 oder .97, sondern kleiner.

Für die Berechnung des Exponenten haben wir ein anderes mathematisches Verfahren benutzt als es etwa Lotka noch 1926 benutzt hat. Entwickelt hat das eine Gruppe um den US-Amerikaner Newman, der viel publiziert dazu (allerdings verstehe ich persönlich die Mathematik dahinter nicht wirklich, um nicht zu sagen gar nicht), das Coole ist, dass andere Mathematiker aufbauend auf Newman et al. ein Python Script veröffentlicht haben, dass dieses Verfahren handhabbar macht auch für Mathe-Laien wie mich und meine Mitarbeiter. Da gibt man eigentlich nur seine Messergebnisse ein, und dieses Script berechnet den Exponenten und bestimmt auch den genauen Typ der Verteilung.

Was Modelle betrifft: Zunächst müssen wir mal sehen, ob diese Verteilung robust ist, also ob wir genau so eine Verteilung auch für Jahre vor 2016 und danach sehen. Wenn die Verteilung robust ist, dann kann man natürlich auch modellieren, man kann zum Beispiel auf Basis der Zahl besonders erfolgreicher Paper relativ exakt hochrechnen, wie viele Paper insgesamt aufgegriffen wurden, daraus lassen sich relativ genaue Abschätzungen ableiten zum Beispiel zur Bestimmung der journalistischen Beobachtungsleistung, die, das kann man ja schon jetzt sehen, sehr, sehr begrenzt ist, wissenschaftliche Erkenntnisgenese läuft bis auf wenige Ausnahmen unter Ausschluss der Öffentlichkeit ab.

Markus Lehmkuhl

Markus Lehmkuhl

Volker Stollorz schreibt:

20. Juni 2018 um 08:42 Uhr

Dennoch würde ich als Wissenschaftsjournalist sagen: die wenigen wirklich dicken Klopper, die also wirklichen „Major Biomedical Breakthroughs“ im Sinne von Rogers Hollingsworth, die landen heute relativ zuverlässlich in der massenmedialen Öffentlichkeit. Bei der Entdeckung der Doppelhelix Struktur der DNA war das noch anders. Da erschien erst 6 Monate später der erste kleine Artikel im britischen Observer. Oder?

Markus Lehmkuhl schreibt:

21. Juni 2018 um 11:25 Uhr

Ich weiß es nicht, manches spricht dafür. Vorrangig der Umstand, dass Forscher ihre Breakthroughs wenn irgend möglich heute ja zuverlässlig an die vermeintlichen Top-Journals schicken. Denen obliegt es dann, die echten von den nicht so echten zu unterscheiden, was ja, wie alle wissen, nicht immer zuverlässig gelingt. Das war bis in jüngste Zeit ja nicht immer der Fall. Die Entdeckung der high temperature Supraleiter durch Bednorz und Müller wurde noch 1986 in der „Zeitschrift für Physik“ veröffentlicht, 1987 schon haben die dafür den Nobelpreis gekriegt. Wenn das heute einer machte, würde er wahrscheinlich nicht vom Journalismus wahrgenommen. Aber man könnte das mal untersuchen, indem man die Resonanz der Ergebnisse systematisch erhebt, für die Nobelpreise vergeben wurden. Sonst wüsste ich nicht, wie man „Breakthrough“ passabel operationalisert kriegt.

Marcus Anhäuser schreibt:

26. Juni 2018 um 04:04 Uhr

Ich tippe mal drauf, dass über die allermeisten Nobelpreise-Entdeckungen zum Zeitpunkt des Papers nicht berichtet wurde: Weil es sich häufig um Methoden handelt, die Laienpresse sowieso nicht interessiert. Viele Effekte sind so bizarr und abstrakt, dass sie schlicht schwierig zu vermitteln sind und letztlich erweisen sich viele Entdeckungen erst auf längere Sicht als Nobelpreis würdig. Hinzu kommt dass die Wissenschafts-PR ja erst in den letzten zwei Jahrzehnten erst so richtig in fahrt gekommen ist, was das „Darauf stoßen“ angeht.

Pepe Baluu schreibt:

26. Juni 2018 um 05:19 Uhr

Amüsanter Beitrag. Ich vermute ungewollte Satire oder Volontärsausbildung. Aber ernsthaft: Was interessant wäre, sind fundierte und auch quantitative Informationen dazu, welche nicht-wissenschaftlichen Faktoren dazu führen, dass bestimmte wissenschaftlichen Erkenntnisse in diesem oder jenem Journal publiziert und dann auch von Medien aufgegriffen und so oder so umgesetzt werden. Hinzu kommt, ob es nicht nur in den Primär-Journals wie NEJM etc., sondern auch in den Publikums- und Fachmedien wie Medscape, Ärzteblatt usw. einen Publikationsbias hinsichtlich negativer Ergebnisse gibt. Nicht-wissenschaftliche Faktoren wären z.B. kommerzielle Interessen, aber nicht allein. Auch in der Wissenschaft und in der Wissenschaftskommunikation gibt es so etwas wie Mainstream und Klüngel.